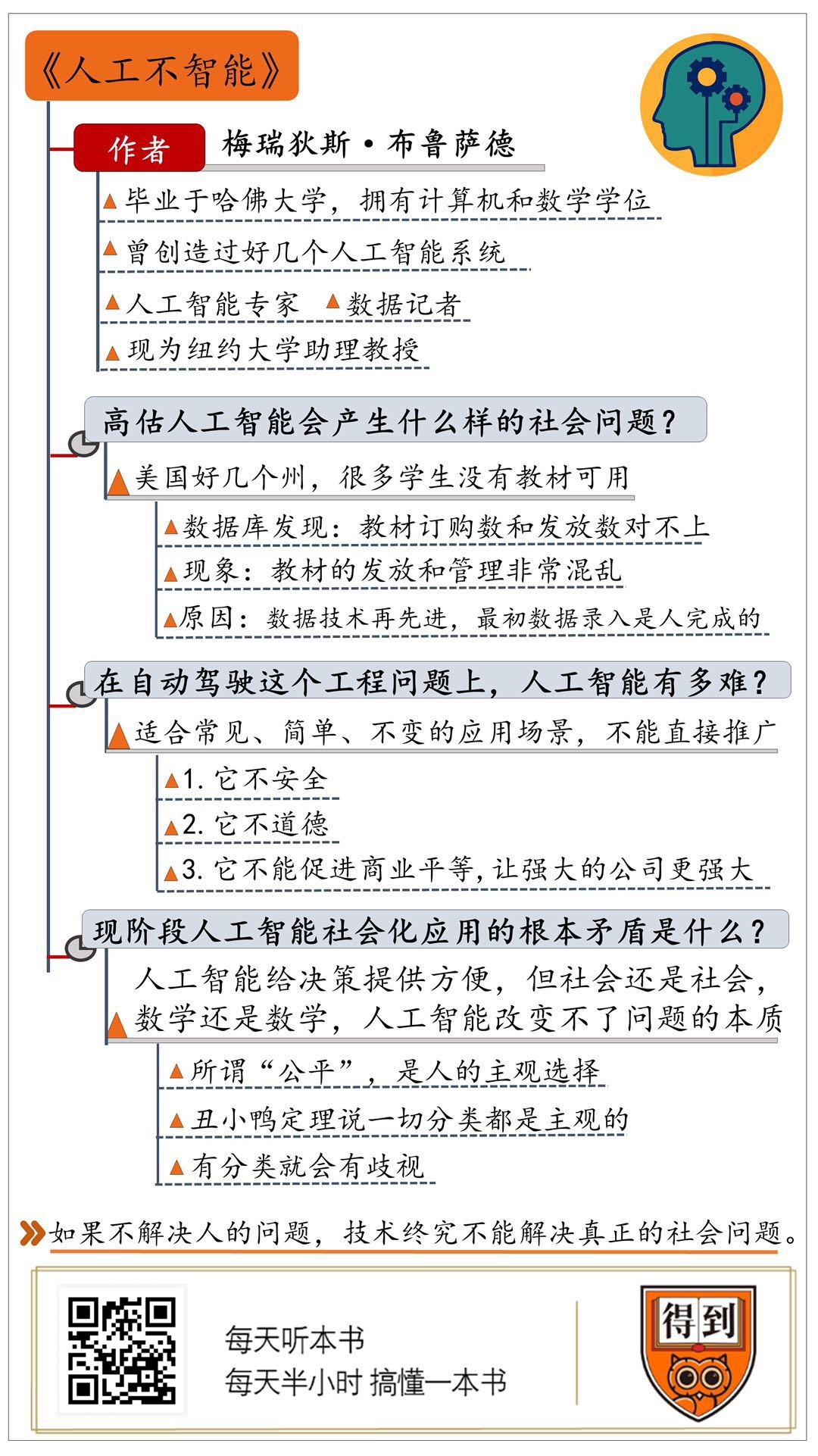

人工不智能

首先直接抛结论:人工智能想要完全取代人类还有很长一段路要走,我们现在对人工智能的恐慌完全是过度想象。

在可预见的未来里,人工智能并不会导致大面积的失业。而我们现在的人过度依赖计算机算法,反而带来了更多的社会问题。人们经常说计算机改变了世界,而本书的作者会告诉你计算机并没有改变什么,社会还是这个社会,计算机并没有解决我们的社会问题。

通过三部分来解读

- 高估人工智能会产生什么样的社会问题

- 自动驾驶有多难

- 看清现阶段人工智能社会化应用的根本矛盾

一、高估人工智能会产生什么样的社会问题

现在有一种情绪被称为技术沙文主义(原指极端的、不合理的、过分的爱国主义,因此也是一种民族主义。如今的含义也囊括其他领域,主要指盲目热爱自己所处的团体,并经常对其他团体怀有恶意与仇恨),认为一切社会问题都可以用技术来解决。

例子:给中小学生发放课本,如何确保每个人都拿到课本?美国有好几个洲的学生没有教材可用。

教育本质上是因人而异的、混乱的、动态的系统,而公共教育系统是一个统一的,标准化的,最好是不变的系统。比尔盖茨和梅琳达基金会在推广的共同核心课程系统,类似于中国全国统一性教学大纲和标准化考试,但却遭到了抵制(不民主,不同学区的水平差异大,应试教育负面影响大),因此美国的公共教育非常混乱。盖茨是想把教育问题当作工程问题来解决,而工程问题本质上是数学,是要在一个定义良好的环境里,用定义良好的参数来描写一个定义良好的问题。而教育问题有着更多复杂性的社会问题,恰恰不能定义良好。

因此,计算机善于解决工程问题,而解决不了社会问题,这也是为什么计算机技术发展那么多年,美国的基础教育几乎没有发生任何进步。

二、自动驾驶有多难

结论:现阶段所有的人工智能都有一个根本的弱点。这个弱点就是它们高度依赖数据,都是对过去经验的总结,它们没有办法预测“没见过”的事情,因此应用场景有限。

国际汽车工程师学会弄了一个标准,把自动驾驶汽车一共分为五个级别:

- 0:没有自动驾驶

- 1:某种时候某种程度提供辅助,如自动刹车,保持车道

- 2:有的时候可以自己开,但要人盯着(特斯拉)

- 3:不用盯着车可以自己开,但要是车发出信号,需要接管驾驶

- 4:在某些环境和条件下实现自动驾驶,人可以睡觉

- 5:完全自动驾驶,不管什么天气和路况

截至此时此刻,任何一家公司的自动驾驶技术都没有超过二级。而有些专家认为,五级自动驾驶是一个永远都达不到的目标。因为人工智能处理不了意外(鸭子,鸟,塑料袋,石头)。

- 计算机只关心物体的运动趋势,估算出速度,预测路线,跟车的路线是否有冲突

- 路边指示牌的识别,图像识别技术很难

- 除安全问题外,还有道德问题(撞墙还是撞小学生?),经济学问题(二八法则,你花20%的时间就能解决80%的问题,剩下80%的时间解决20%的问题。2%的数据能训练出80%的问题,剩下的20%的问题,用98%的数据也未必能解决)

- 数据模型不能推广,各地区国家法规不一样

- 人工智能时代的商业帝国一定是数据帝国,算法都是现成的,真正值钱的是数据。谁掌握了数据,谁的自动驾驶技术才有市场。(不能促进商业平等)

三、看清现阶段人工智能社会化应用的根本矛盾

从美国司法制度说起。中国犯罪是根据罪行来量刑,惩罚力度跟你是什么样的人没关系,而美国法官在判刑时会看是什么样的人,平时表现良好可以轻判,指导思想是犯人将来再次犯罪的可能性大小。

以前是根据法官的主观判断,并不靠谱,现在用算法来判断,但算法预测的是概率,就存在被冤枉的情况

只要用过去的经验去预测未来就一定会有这个矛盾,产生经验的是一批人,要被影响的是另一批人,相当于新人要为前人犯的过错买单,这是一切基于经验的本质缺陷

算法可以根本不考虑种族,但种族就隐藏在数据之中(黑人总体再犯罪率高,黑人打高分的比例就必然高。每个分数代表的人群中被冤枉的比例是固定的,那既然黑人总体打高分的比例高,那么其中被冤枉的黑人就一定更多)

丑小鸭定理说,一切分类都是主观的,有分类就会有歧视,此事古难全

技术确实能让事情更有效率,但写程序的是人,录入数据的是人,使用系统的还是人,如果解决不了人的问题,技术终究解决不了真正的社会问题